LR 是机器学习中的一个重要概念,它代表逻辑回归(Logistic Regression)。逻辑回归是一种核算办法,常用于二分类问题,即猜测成果只要两种或许的状况。LR 的基本思维是经过树立数学模型来描绘自变量与因变量之间的联系,然后完成猜测的意图。

LR 模型的首要特点是运用 Sigmoid 函数作为激活函数,将线性回归模型的输出转换为概率值,然后完成二分类猜测。LR 模型的参数一般经过梯度下降法进行优化,以进步模型的猜测准确性。

LR 模型在许多范畴都有广泛的运用,如垃圾邮件过滤、情感剖析、用户行为猜测等。LR 模型的长处是模型简略、易于完成,而且能够处理非线性联系。可是,LR 模型也有其局限性,如难以处理多分类问题、简略受到过拟合的影响等。

总的来说,LR 是机器学习中的一种重要办法,它经过树立数学模型来完成二分类猜测。LR 模型在许多范畴都有广泛的运用,而且具有模型简略、易于完成等长处。可是,LR 模型也有其局限性,如难以处理多分类问题、简略受到过拟合的影响等。

深化解析机器学习中的逻辑回归(LR)算法

逻辑回归(Logistic Regression,简称LR)是机器学习中一种经典的分类算法,广泛运用于各种分类使命中。虽然其称号中带有“回归”二字,但实践上逻辑回归是一种用于处理二分类问题的核算学习办法。本文将深化解析逻辑回归算法的原理、完成办法以及在实践运用中的优势。

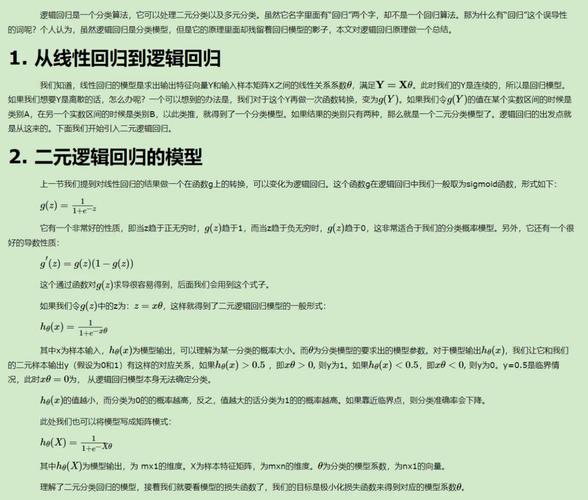

二、逻辑回归的原理

逻辑回归的中心思维是经过一个线性函数的组合,将特征和类别之间的联系建模为一个概率。具体来说,逻辑回归假定数据遵守伯努利分布,经过极大化似然函数的办法,运用梯度下降来求解参数,然后完成将数据二分类的意图。

三、逻辑回归的公式与丢失函数

逻辑回归的公式如下:

\\[ P(Y=1|X) = \\frac{1}{1 e^{-(\\beta_0 \\beta_1X_1 \\beta_2X_2 ... \\beta_nX_n)}} \\]

谈判,\\( P(Y=1|X) \\) 表明在给定特征 \\( X \\) 的状况下,样本归于正类的概率;\\( \\beta_0, \\beta_1, \\beta_2, ..., \\beta_n \\) 为模型参数。

逻辑回归的丢失函数为穿插熵丢失函数(Cross-Entropy Loss),也称为对数丢失(Log Loss),其公式如下:

\\[ L(\\theta) = -\\frac{1}{N} \\sum_{i=1}^{N} [y_i \\log(\\hat{y}_i) (1 - y_i) \\log(1 - \\hat{y}_i)] \\]

四、逻辑回归的完成办法

逻辑回归的完成办法首要绵亘以下过程:

1. 数据预处理:对输入特征进行标准化处理,进步模型练习的功率。

2. 梯度下降法:经过迭代优化模型参数,使得丢失函数最小化。

3. 模型评价:运用穿插验证等办法评价模型功能。

五、逻辑回归在实践运用中的优势

逻辑回归在实践运用中具有以下优势:

1. 简略易完成:逻辑回归算法原理简略,易于了解和完成。

2. 高效:逻辑回归算法核算功率高,适用于大规模数据集。

3. 可解说性强:逻辑回归模型参数具有清晰的物理含义,便于解说。

4. 适用于二分类和多分类问题:逻辑回归不只能够用于二分类问题,还能够经过一些技巧扩展到多分类问题。

六、逻辑回归的局限性

虽然逻辑回归在实践运用中具有许多优势,但也存在一些局限性:

1. 对异常值灵敏:逻辑回归模型对异常值较为灵敏,或许导致模型功能下降。

2. 无法处理非线性联系:逻辑回归模型假定特征与类别之间存在线性联系,无法处理非线性联系。

3. 无法处理高维数据:当特征维度较高时,逻辑回归模型的功能或许会受到影响。

逻辑回归作为一种经典的分类算法,在机器学习中具有广泛的运用。本文深化解析了逻辑回归的原理、完成办法以及在实践运用中的优势与局限性,期望对读者有所协助。

未经允许不得转载:全栈博客园 » 机器学习 lr,二、逻辑回归的原理

全栈博客园

全栈博客园 ai机器学习课程,敞开智能年代的常识之旅

ai机器学习课程,敞开智能年代的常识之旅 ai处理器,推进智能年代的引擎

ai处理器,推进智能年代的引擎 ai音乐,未来音乐创造的革命性力气

ai音乐,未来音乐创造的革命性力气 ai归纳布景,技能开展、使用范畴与未来展望

ai归纳布景,技能开展、使用范畴与未来展望 机器学习研讨方向,机器学习研讨方向的未来趋势与应战

机器学习研讨方向,机器学习研讨方向的未来趋势与应战 ai歌唱,科技与艺术的完美交融

ai歌唱,科技与艺术的完美交融 机器学习可视化,机器学习可视化的重要性

机器学习可视化,机器学习可视化的重要性 ai魔镜归纳实践,从神话到实际的跨过

ai魔镜归纳实践,从神话到实际的跨过