1. Keras:Keras是一个高档神经网络API,它运转在TensorFlow之上,但也能够在Theano上运转。Keras在R中有一个接口,称为`keras`,它答运用户轻松构建和练习杂乱的神经网络模型。

2. TensorFlow:TensorFlow是一个由Google开发的开源软件库,用于数据流编程和不同类型的核算。R中的`tensorflow`包供给了对TensorFlow的接口,答运用户在R中直接运用TensorFlow进行深度学习。

3. MXNet:MXNet是一个由Apache基金会支撑的深度学习结构,它支撑灵敏的编程模型和高效的核算。R中的`mxnet`包供给了对MXNet的接口。

4. xgboost:尽管xgboost首要用于梯度提高树(GBM)的构建,但它也能够用于深度学习,尤其是在处理大规模数据集时。

5. DeepLearning:这是一个R包,它供给了构建和练习深度学习模型的根本东西。

6. h2o:H2O是一个开源的机器学习渠道,它供给了包含深度学习在内的多种机器学习算法。R中的`h2o`包供给了对H2O的接口。

7. neuralnet:这是一个相对简略的神经网络包,它供给了构建和练习前馈神经网络的根本功用。

8. DMwR2e:这是一个数据发掘的包,它包含了一些深度学习相关的功用,如主动编码器和卷积神经网络。

9. deepnet:这是一个供给多种深度学习模型的包,包含前馈神经网络、卷积神经网络和循环神经网络。

10. caret:尽管caret首要用于模型练习和猜测,但它也支撑一些深度学习模型,如xgboost和h2o。

这些库和包为R言语用户供给了丰厚的深度学习东西和功用,使得在R中进行深度学习成为或许。与专门为深度学习规划的言语(如Python)比较,R在深度学习方面的功用和灵敏性或许略有缺乏。因而,关于大规模或杂乱的深度学习使命,Python或许是一个更好的挑选。

R言语深度学习入门攻略

一、R言语简介

R言语是一种专门用于核算核算和图形表明的编程言语。它具有丰厚的数据剖析和可视化功用,能够处理各种类型的数据,包含数值、文本和图画等。R言语具有巨大的社区和丰厚的包(packages),使得它在数据剖析范畴具有极高的灵敏性和可扩展性。

二、R言语深度学习根底

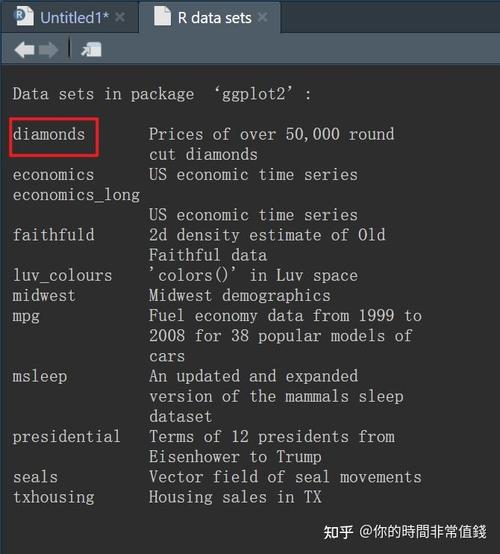

深度学习是机器学习的一个分支,它经过模仿人脑神经网络的结构和功用,完成对数据的主动学习和特征提取。在R言语中,咱们能够运用一些专门的包来进行深度学习,如Keras、TensorFlow和MXNet等。

三、Keras包在R言语中的运用

Keras是一个高档神经网络API,它能够在R言语中经过keras包进行运用。Keras供给了丰厚的神经网络层和优化器,使得构建和练习深度学习模型变得十分简略。

以下是一个运用Keras包在R言语中构建一个简略的神经网络模型的示例:

```R

library(keras)

创立模型

layer_dense(units = 64, activation = 'relu', input_shape = c(784)) %>%

layer_dense(units = 64, activation = 'relu') %>%

layer_dense(units = 10, activation = 'softmax')

编译模型

loss = 'categorical_crossentropy',

optimizer = optimizer_rmsprop(),

metrics = list('accuracy')

练习模型

x_train, y_train,

epochs = 10,

batch_size = 128,

validation_split = 0.2

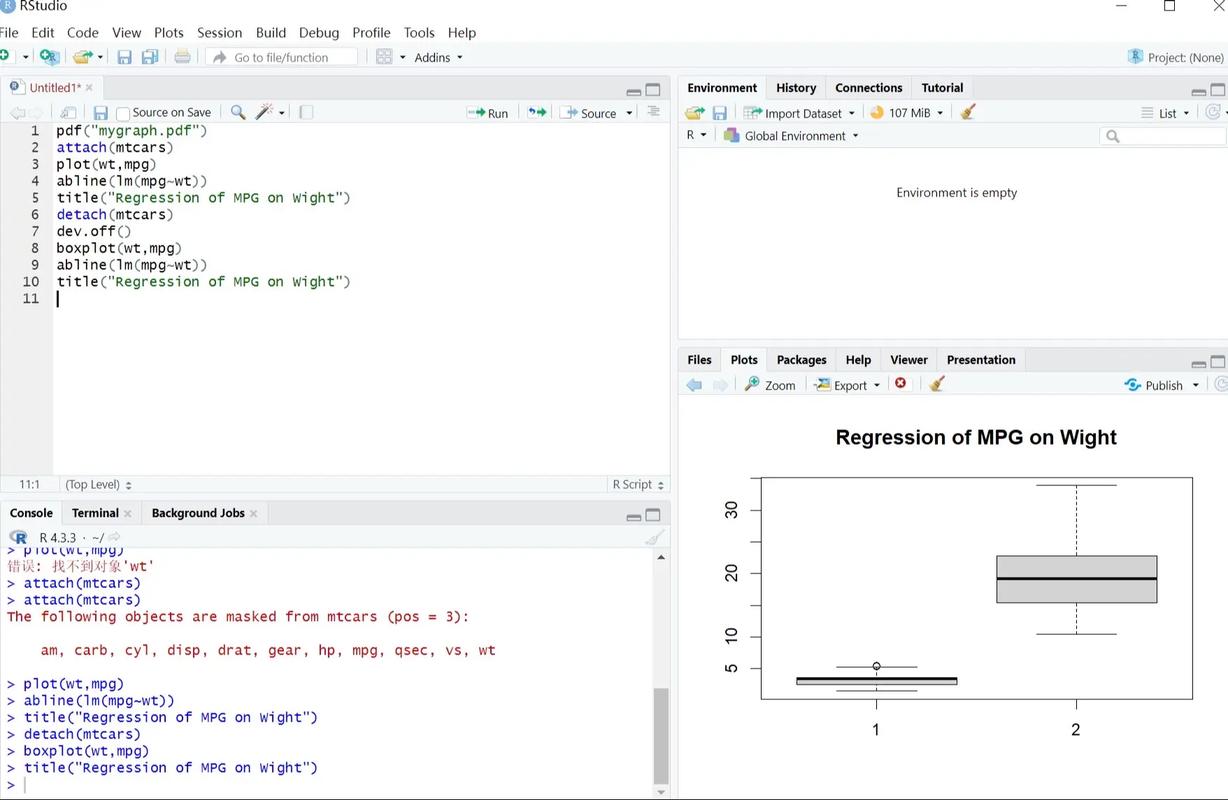

四、TensorFlow在R言语中的运用

TensorFlow是一个开源的机器学习结构,它供给了丰厚的东西和库来构建和练习深度学习模型。在R言语中,咱们能够运用tensorflow包来调用TensorFlow的功用。

以下是一个运用tensorflow包在R言语中构建一个简略的卷积神经网络(CNN)模型的示例:

```R

library(tensorflow)

创立模型

tf_layer_conv_2d(filters = 32, kernel_size = c(3, 3), activation = 'relu', input_shape = c(28, 28, 1)) %>%

tf_layer_max_pooling_2d(pool_size = c(2, 2)) %>%

tf_layer_conv_2d(filters = 64, kernel_size = c(3, 3), activation = 'relu') %>%

tf_layer_max_pooling_2d(pool_size = c(2, 2)) %>%

tf_layer_flatten() %>%

tf_layer_dense(units = 128, activation = 'relu') %>%

tf_layer_dense(units = 10, activation = 'softmax')

编译模型

loss = 'categorical_crossentropy',

optimizer = optimizer_adam(),

metrics = list('accuracy')

练习模型

x_train, y_train,

epochs = 10,

batch_size = 128,

validation_split = 0.2

全栈博客园

全栈博客园 DART探测器,人类行星防护的前锋

DART探测器,人类行星防护的前锋 go下载官网,怎么运用Go言语下载官网资源

go下载官网,怎么运用Go言语下载官网资源 大疆go,大疆GO——敞开智能拍照新纪元

大疆go,大疆GO——敞开智能拍照新纪元 ruby和python,两种盛行编程言语的全面比照

ruby和python,两种盛行编程言语的全面比照 python编程怎样读

python编程怎样读 怎样运转python脚本,从入门到实践

怎样运转python脚本,从入门到实践 python怎么装置,从入门到环境建立

python怎么装置,从入门到环境建立